Comment construire un modèle de Machine Learning avec des données anonymes ?

L'apprentissage automatique, également connu sous le nom de Machine Learning, a profondément modifié la manière dont les ordinateurs exécutent des tâches, leur permettant d'apprendre à partir de modèles et de données sans nécessiter de programmation explicite. Cependant, l'accès aux données pour le Machine Learning présente des défis spécifiques en raison des préoccupations relatives à la confidentialité et des contraintes réglementaires, rendant le processus complexe et chronophage. De plus, l'utilisation de modèles basés sur des données personnelles augmente le risque de ré-identification si ces données devaient être divulguées publiquement. Pour résoudre ces défis, Octopize a développé avatar, son logiciel d'anonymisation des données, qui permet l'utilisation de données synthétiques anonymes pour l'entraînement de modèles d’IA sans compromettre la vie privée des individus. En établissant un équilibre entre la protection de la confidentialité et l’utilisation des données, celles-ci peuvent être exploitées pour tous les usages secondaires comme celui de promouvoir la recherche médicale, d’alimenter un algorithme de prédiction etc. tout en préservant la confiance des individus ou patients dans le secteur de la santé.

Le Machine Learning, un outil puissant…Qui pose aussi quelques difficultés

L'apprentissage automatique, souvent désigné sous le terme de Machine Learning, constitue une approche puissante qui enseigne aux ordinateurs comment accomplir des tâches à partir de données, sans nécessiter de programmation explicite. Cette méthode repose sur la capacité des machines à améliorer leurs performances au fil du temps en identifiant des schémas dans de vastes ensembles de données. Par le biais d'un processus d'entraînement, les algorithmes sont formés sur des données étiquetées afin de détecter des modèles et de fournir des prédictions ou prendre des décisions. Cette technologie a des applications variées, telles que la reconnaissance d'images et de la parole, les systèmes de recommandation, les soins de santé, la finance et bien d'autres encore. Malgré sa complexité apparente, le Machine Learning simplifie notre quotidien en permettant aux machines d'apprendre et de prendre des décisions autonomes, contribuant ainsi à l'évolution de la technologie et à l'amélioration de notre vie quotidienne.

Toutefois, dans le contexte actuel, l'obtention d'une grande quantité de données requise pour entraîner les modèles pose un défi majeur. Deux obstacles principaux se démarquent : la complexité d'accès aux données et la menace pesant sur la confidentialité des individus.

1) Un accès aux données difficile

L'accès aux données pour le Machine Learning peut s'avérer être un processus long et ardu. En particulier, concernant les données de santé qualifiées de sensibles, cela implique d'obtenir les autorisations nécessaires, de garantir la conformité aux réglementations sur la confidentialité (HIPAA ou RGPD), et de mettre en place des accords sécurisés de partage de données avec les institutions concernées. Les chercheurs et les data scientists doivent

souvent suivre des procédures d'examen rigoureuses et obtenir l'approbation des comités d'éthique ou des conseils institutionnels avant d'accéder et d'utiliser ces données. Ces comités évaluent les objectifs de recherche, les risques potentiels pour la confidentialité des patients, et la pertinence des mesures de sécurité avant d'autoriser l'accès, un processus qui peut s'étendre sur des mois, voire plus, selon la complexité et la sensibilité des données. Par ailleurs, la dissémination des données peut également compliquer l'accès et l'intégration des données. Les données de santé étant souvent dispersées entre plusieurs établissements de soins, la collecte d'un ensemble de données complet pour l'entraînement des modèles de Machine Learning peut s'avérer complexe. Des accords de partage des données doivent être conclus avec chaque organisation, et des problèmes de compatibilité et d'interopérabilité peuvent surgir en raison des divers formats, systèmes et protocoles utilisés, prolongeant ainsi le processus d'obtention d'accès aux données. En résumé, l'accès aux données de santé pour le Machine Learning est entravé par d'importants obstacles liés à la confidentialité, aux cadres réglementaires, et à la complexité de l'intégration des données, entraînant des délais et des processus fastidieux pour obtenir cet accès.

2) Une menace pour la confidentialité des individus

Un autre défi majeur réside dans les préoccupations concernant la confidentialité des données de santé. Entraîner un modèle sur des informations sensibles relatives aux patients comporte le risque de ré-identifier des individus, un attaquant pouvant déduire l'appartenance au jeu de données à partir des prédictions du modèle, ce qu'on appelle une attaque par inférence d'appartenance. En effet, même si les données brutes ne sont pas directement accessibles, le modèle encode toutes les informations des données, et sans une protection appropriée contre ces attaques spécifiques, subsiste le risque sous-jacent d'extraction d'informations à partir du modèle.

3) L'anonymisation comme solution

Pour résoudre ces défis et accélérer l'accès aux données médicales pour la création de modèles de Machine Learning, l'utilisation de techniques d'anonymisation s'avère cruciale. Éviter tout risque de ré-identification des individus est impératif lorsque des performances comparables peuvent être obtenues avec des données anonymisées plutôt qu'avec les données d'origine. L'anonymisation, correctement appliquée, réduit considérablement ce risque et simplifie l'accès aux données en éliminant les liens avec les individus réels : il n'y a donc plus aucune raison de risquer la ré-identification des patients. Chez Octopize, notre logiciel avatar offre une anonymisation unique qui préserve qualité et utilité des données.

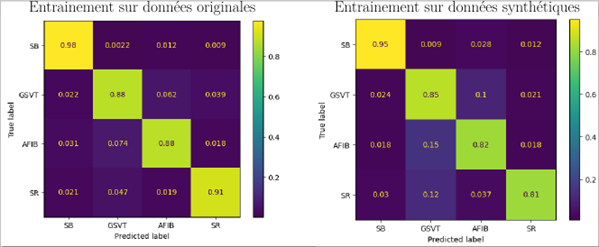

Nous disposons de métriques uniques pour prouver ce respect de la confidentialité répondant ainsi aux normes européennes en matière d'anonymisation (avis du CEPD du 10/2014). Nous avons également démontré empiriquement que les modèles de Machine Learning formés sur des données synthétiques et anonymes présentent la même capacité prédictive que ceux formés sur des données réelles, en particulier dans le domaine de la santé.[2][3]. Ceci est illustré dans la figure ci-dessous [4].

Conclusion

En conclusion, l'accès aux données de santé pour le Machine Learning présente des défis majeurs en termes de protection de la confidentialité et de respect des réglementations, avec un risque potentiel pour la vie privée des individus via les modèles. Toutefois, l'utilisation de techniques d'anonymisation telles que la méthode avatar assure la conformité réglementaire tout en protégeant l'identité des individus. Cette approche permet aux chercheurs d'accéder rapidement aux données, favorisant ainsi les avancées dans les soins de santé tout en préservant la confidentialité, les normes éthiques et la confiance du public.

Références :

[1] Shokri et. al, Membership Inference Attacks against Machine Learning Models,. https://doi.org/10.48550/arXiv.1610.05820

[2] Guillaudeux et. al, Patient-centric synthetic data generation, no reason to risk

re-identification in biomedical data analysis, https://doi.org/10.1038/s41746-023-00771-5

[3] Bennis et.al, Application of a novel Anonymization Method for Electrocardiogram data, https://doi.org/10.1145/3485557.3485581

[4] Barreteau et. al, Génération de signaux anonymes à partir de données non anonymes par modèle de mélange linéaire local, GRETSI 2023, (bientôt disponible)